基于多模态感知与深度学习框架,通过视频流实时分析技术实现毫秒级动态捕捉,采用并行计算架构处理高帧率视频流;骨骼关键点追踪运用人体姿态估计模型,通过非接触式关节运动轨迹建模精准还原行为特征;异常行为检测算法融合时空注意力机制与模式匹配技术,建立自适应行为基线库,结合上下文语义实现跌倒、闯入、违规操作等200+异常模式的智能判别与分级预警,形成从数据采集、特征提取到决策输出的全链路分析能力,在保障隐私脱敏处理的前提下,满足工业、安防、医疗等多场景下的精准行为感知需求。

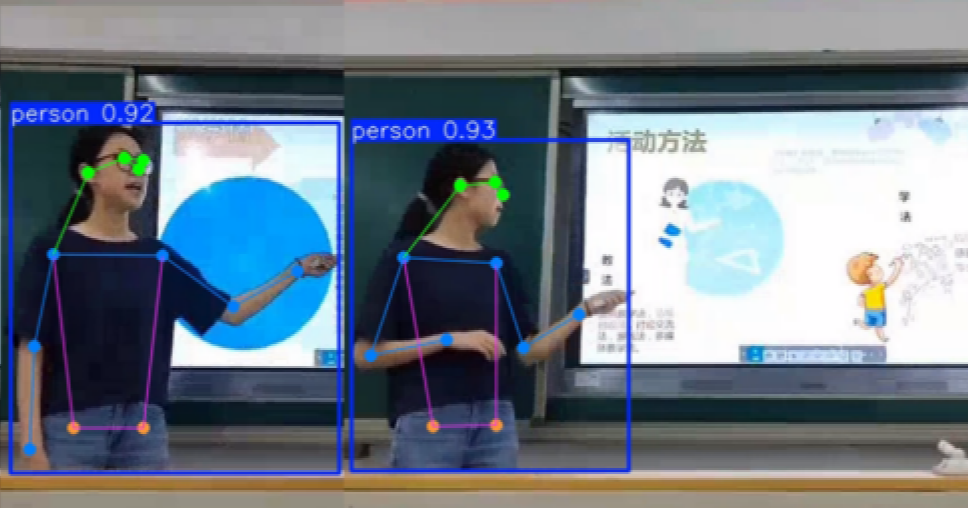

师范生在微格教室说课过程中的行为分析:分析师范生讲课视频中,讲课人的体态变化、肢体动作交互、面向课堂与背对课堂的时长;背对课堂,积极课堂行为,不良姿态时长和比列、书写板书、走下讲台、坐下时间及比列,各种行为的课程用时比列

师范生姿态分析要点: 1.低头情况 2.背对学生时间 3.板书时间 4. 僵持不动时间 5.积极课堂行为(姿态动作丰富时长和比列) 6. 不良姿态时长比列 7.走动时长和比列 8.接打电话次数时间

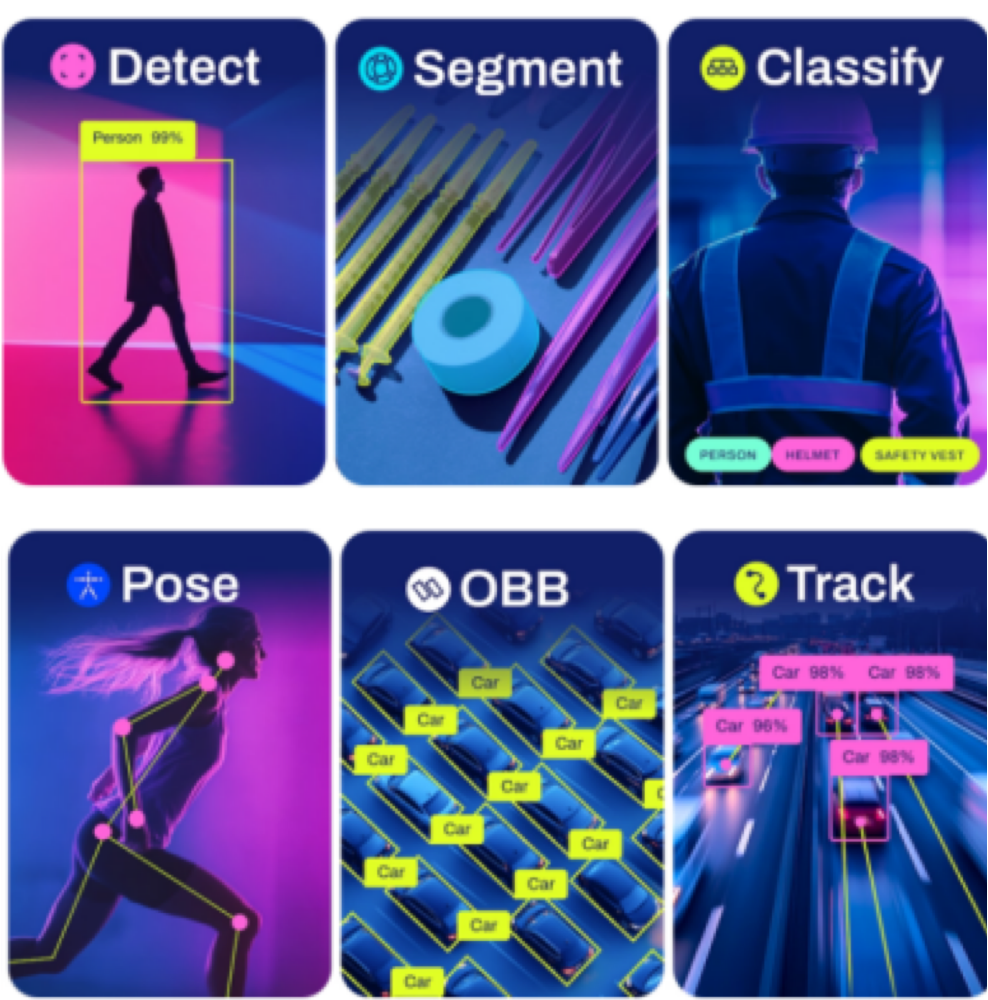

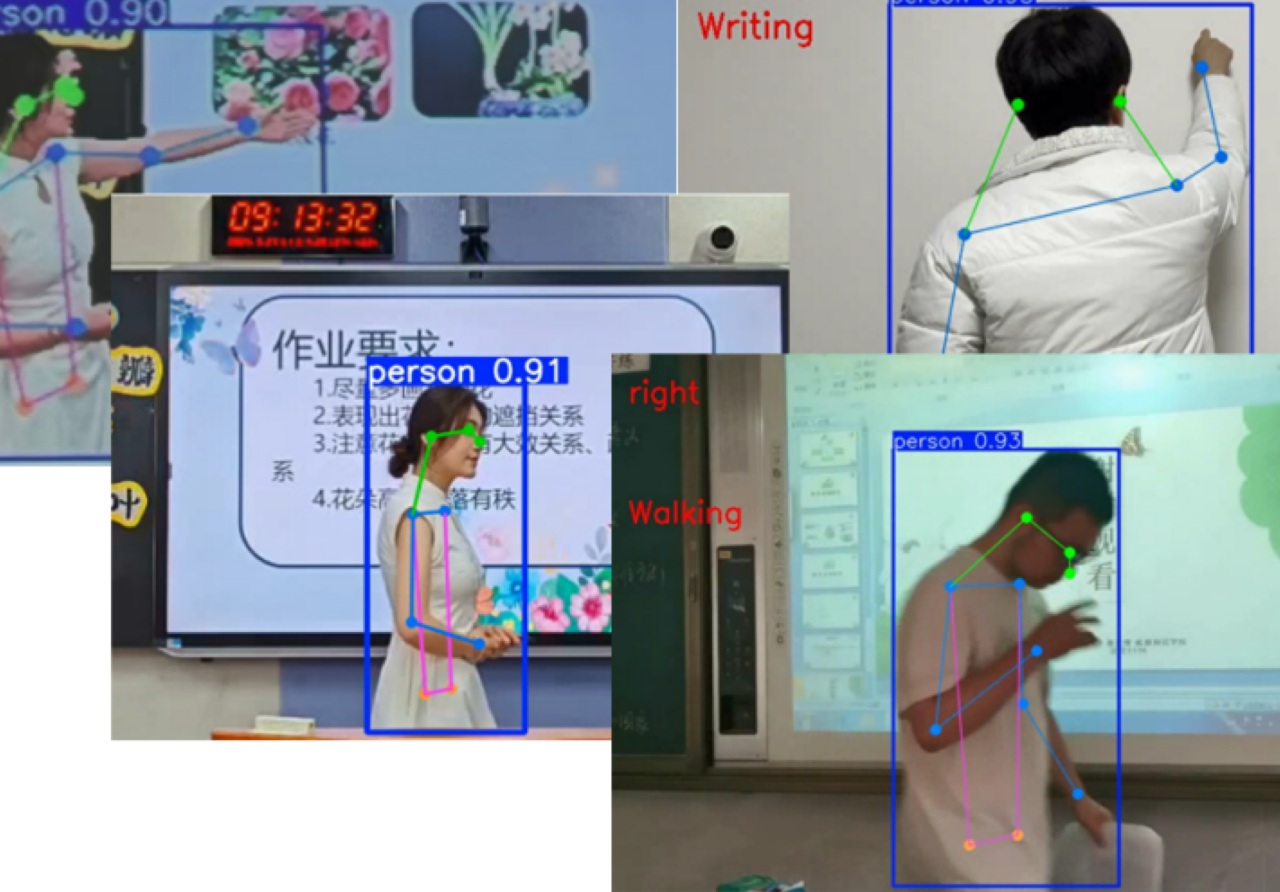

课堂行为分析与个性化学习系统 人体关键点检测:使用 YOLOv11进行人体关键点检测,实时提取人体关键点(如头部、肩膀、手臂、腿部)。

体态分析:基于关键点角度计算身体是否倾斜、弯曲等异常体态。判断是否存在长时间固定姿势或快速频繁移动。

肢体动作交互:通过时序模型分析动作连续性。提取讲课中手势特征,如是否指示、抬手等动作。

镜头互动分析:通过关键点判断身体朝向,结合面部方向统计讲课人与镜头的交互时长。